Nueva cámara imita los movimientos involuntarios del ojo humano para crear imágenes más nítidas y precisas para robots, teléfonos inteligentes y otros dispositivos de captura de imágenes.

Científicos informáticos han inventado un mecanismo de cámara que mejora la capacidad de los robots para ver y reaccionar al entorno que los rodea. Inspirado en el funcionamiento del ojo humano, el equipo de investigación, liderado por la Universidad de Maryland, desarrolló un innovador sistema de cámara que imita los pequeños movimientos involuntarios utilizados por el ojo para mantener una visión clara y estable a lo largo del tiempo. El prototipo y las pruebas de la cámara, llamada Cámara de Eventos Mejorada con Microsacadas Artificiales (AMI-EV), se detallan en un artículo publicado recientemente en la revista Science Robotics.

Avances en la Tecnología de Cámaras de Eventos

“Las cámaras de eventos son una tecnología relativamente nueva que rastrea objetos en movimiento mejor que las cámaras tradicionales, pero las cámaras de eventos actuales tienen dificultades para capturar imágenes nítidas y sin desenfoque cuando hay mucho movimiento involucrado”, dijo Botao He, autor principal del artículo y estudiante de doctorado en ciencias de la computación en UMD. “Es un gran problema porque los robots y muchas otras tecnologías, como los autos autónomos, dependen de imágenes precisas y oportunas para reaccionar correctamente a un entorno cambiante. Así que nos preguntamos: ¿Cómo aseguran los humanos y los animales que su visión se mantenga enfocada en un objeto en movimiento?”

Imitando los Movimientos del Ojo Humano

Para el equipo de He, la respuesta fueron las microsacadas, pequeños y rápidos movimientos oculares que ocurren involuntariamente cuando una persona intenta enfocar su vista. A través de estos movimientos mínimos pero continuos, el ojo humano puede mantener el enfoque en un objeto y sus texturas visuales, como el color, la profundidad y las sombras, con precisión a lo largo del tiempo.

“Nos dimos cuenta de que, al igual que nuestros ojos necesitan esos pequeños movimientos para mantenerse enfocados, una cámara podría usar un principio similar para capturar imágenes claras y precisas sin el desenfoque causado por el movimiento”, explicó He.

Implementación Tecnológica y Pruebas

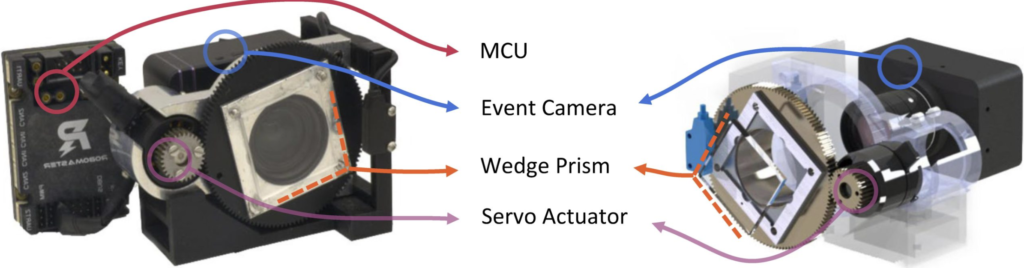

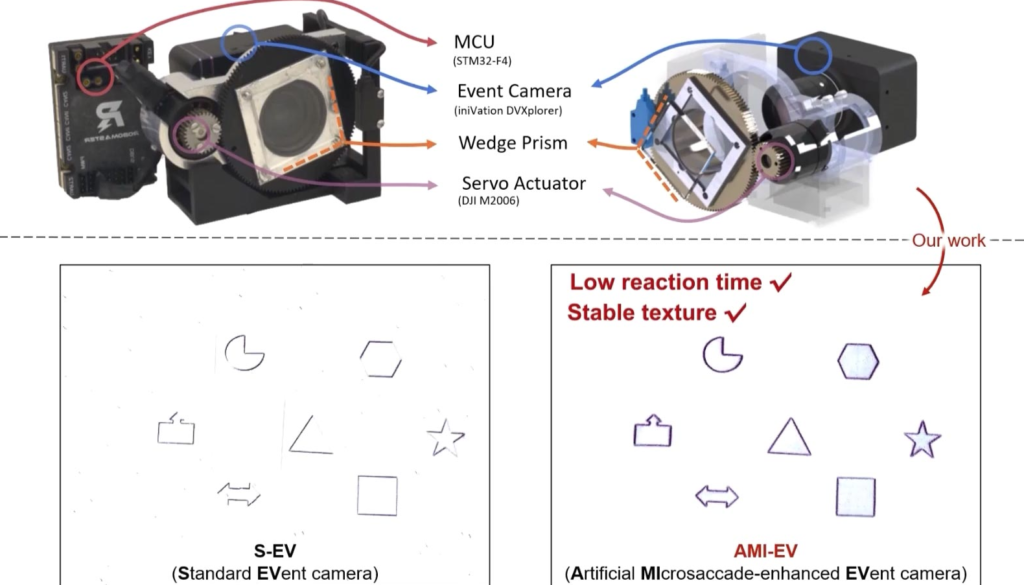

El equipo replicó exitosamente las microsacadas insertando un prisma giratorio dentro de la AMI-EV para redirigir los haces de luz capturados por la lente. El movimiento rotacional continuo del prisma simuló los movimientos que ocurren naturalmente dentro de un ojo humano, permitiendo que la cámara estabilizara las texturas de un objeto grabado de la misma manera que lo haría un humano. El equipo luego desarrolló software para compensar el movimiento del prisma dentro de la AMI-EV, consolidando imágenes estables a partir de las luces cambiantes.

Yiannis Aloimonos, coautor del estudio y profesor de ciencias de la computación en UMD, considera que la invención del equipo es un gran avance en el ámbito de la visión robótica.

“Nuestros ojos toman imágenes del mundo que nos rodea y esas imágenes son enviadas a nuestro cerebro, donde se analizan. La percepción ocurre a través de ese proceso y así es como entendemos el mundo”, explicó Aloimonos, quien también es director del Laboratorio de Visión por Computadora en el Instituto de Estudios Avanzados en Computación de la Universidad de Maryland (UMIACS). “Cuando trabajas con robots, reemplazas los ojos con una cámara y el cerebro con una computadora. Mejores cámaras significan una mejor percepción y reacciones para los robots.”

Impacto Potencial en Diversas Industrias

Los investigadores también creen que su innovación podría tener importantes implicaciones más allá de la robótica y la defensa nacional. Los científicos que trabajan en industrias que dependen de la captura precisa de imágenes y la detección de formas están constantemente buscando maneras de mejorar sus cámaras, y AMI-EV podría ser la solución clave para muchos de los problemas que enfrentan.

“Con sus características únicas, los sensores de eventos y AMI-EV están destinados a ocupar un lugar central en el ámbito de los dispositivos inteligentes portátiles”, dijo Cornelia Fermüller, científica investigadora y autora principal del artículo. “Tienen ventajas distintivas sobre las cámaras clásicas, como un rendimiento superior en condiciones de iluminación extrema, baja latencia y bajo consumo de energía. Estas características son ideales para aplicaciones de realidad virtual, por ejemplo, donde se necesita una experiencia fluida y cálculos rápidos de los movimientos de la cabeza y el cuerpo.”

Mejoras en el Procesamiento de Imágenes en Tiempo Real

En las pruebas iniciales, AMI-EV fue capaz de capturar y mostrar movimientos con precisión en una variedad de contextos, incluyendo la detección del pulso humano y la identificación de formas en rápido movimiento. Los investigadores también descubrieron que AMI-EV podía capturar el movimiento en decenas de miles de fotogramas por segundo, superando a la mayoría de las cámaras comerciales disponibles, que capturan entre 30 y 1000 fotogramas por segundo en promedio. Esta representación más suave y realista del movimiento podría ser fundamental para crear experiencias de realidad aumentada más inmersivas, mejorar la vigilancia de seguridad y mejorar la captura de imágenes astronómicas.

Conclusión y Perspectivas Futuras

“Nuestro sistema de cámara innovador puede resolver muchos problemas específicos, como ayudar a un coche autónomo a identificar qué en la carretera es un humano y qué no lo es”, dijo Aloimonos. “Como resultado, tiene muchas aplicaciones con las que el público en general ya interactúa, como los sistemas de conducción autónoma o incluso las cámaras de los teléfonos inteligentes. Creemos que nuestro sistema de cámara innovador está allanando el camino para sistemas más avanzados y capaces en el futuro.”

Referencia: “Cámara de eventos inspirada en microsacadas para robótica” por Botao He, Ze Wang, Yuan Zhou, Jingxi Chen, Chahat Deep Singh, Haojia Li, Yuman Gao, Shaojie Shen, Kaiwei Wang, Yanjun Cao, Chao Xu, Yiannis Aloimonos, Fei Gao y Cornelia Fermüller, 29 de mayo de 2024, Science Robotics. DOI: 10.1126/scirobotics.adj8124

Además de He, Aloimonos y Fermüller, otros coautores de UMD incluyen a Jingxi Chen (B.S. ’20, ciencias de la computación; M.S. ’22, ciencias de la computación) y Chahat Deep Singh (M.E. ’18, robótica; Ph.D. ’23, ciencias de la computación).

Esta investigación es apoyada por la Fundación Nacional de Ciencia de EE.UU. (Premio No. 2020624) y la Fundación Nacional de Ciencias Naturales de China (Subvenciones Nos. 62322314 y 62088101). Este artículo no refleja necesariamente las opiniones de estas organizaciones.

Fuente :